Olaf Scholz spricht wie gewohnt, mit dieser ihm eigenen stoischen Art. Doch was er sagt, hat es in sich: Die Bundesregierung werde ein AfD-Verbot beim BVerfG beantragen, erklärt der Kanzler. Wirklich? Ist das nun der große Schritt, der schon monatelang landauf, landab diskutiert wurde?

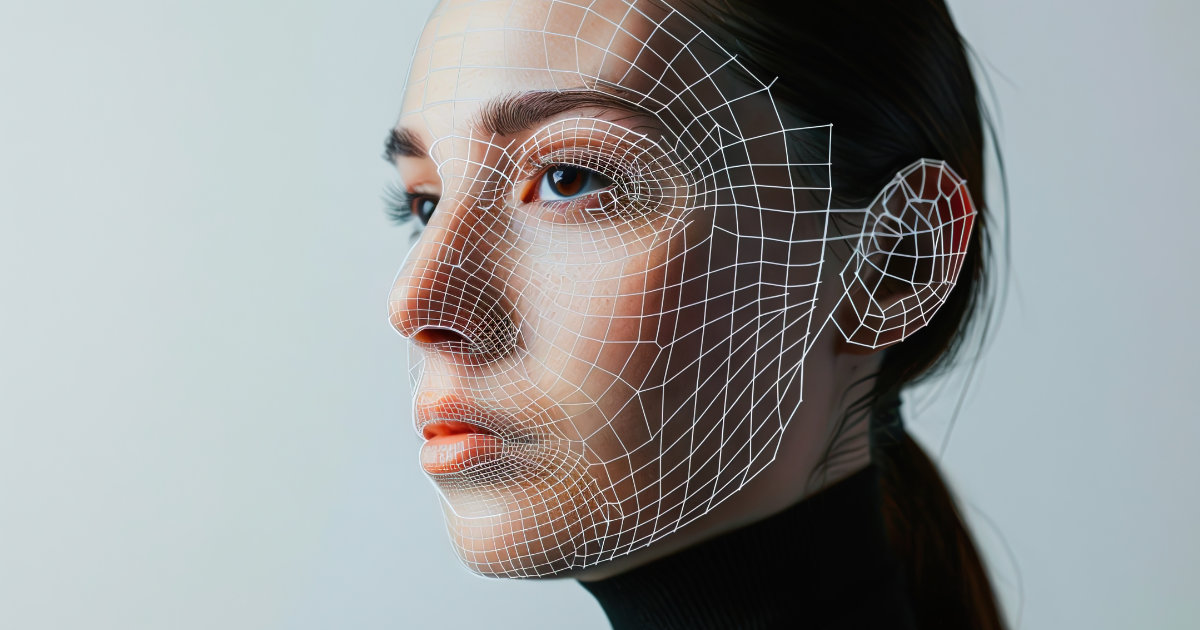

Nein, das Video ist nicht echt. Es zeigt zwar Olaf Scholz bei einer Rede, doch die Worte sind ihm im Nachhinein in den Mund gelegt worden. Es handelt sich um ein sogenanntes Deepfake: mithilfe künstlicher Intelligenz manipulierte Bilder, Tonaufnahmen oder Videos, die zurzeit vielfach durchs Netz geistern.

Nun ist dieses Video leicht als Fälschung zu identifizieren, wenn man das politische Geschehen etwas verfolgt. Aber die dahinterstehende Software ist gut und sie wird immer besser. So gut, dass viele inzwischen in Sorge sind, dass im Zeitalter der Fake-News bald auch in Bildaufnahmen kaum mehr unterscheidbar ist, was wahr ist und was falsch. Das könnte den gesellschaftlichen Diskurs, der durch die Eigendynamik sozialer Netzwerke ohnehin schon Schaden genommen hat, weiter vergiften.

JuMiKo diskutierte neue Regeln für Deepfakes

Die Hamburger Justizsenatorin Anna Gallina (Grüne) hat das Thema auf die Tagesordnung der Konferenz der Justizministerinnen und Justizminister (JuMiKo) Anfang Juni in Hannover gebracht: "Deepfakes verletzen das Persönlichkeitsrecht massiv. Sie sind oft darauf angelegt, Personen des öffentlichen Lebens, aber auch Privatpersonen zu diskreditieren und zu entwürdigen", erklärt Gallina auf Anfrage von beck-aktuell. Sie könnten auch für "gezielte Desinformation" genutzt werden und damit nachhaltigen Schaden für den Ruf von Personen, Institutionen und Unternehmen anrichten. "Deepfakes in sozialen Netzwerken bedrohen außerdem die Qualität der öffentlichen Debatte und damit einen Grundpfeiler einer funktionierenden Demokratie. Wir müssen dafür sorgen, dass auch künftig Fakten statt Fälschungen den Rahmen für Debatten liefern", so Gallina.

Die Ressortchefs bekräftigten auf ihrer Konferenz, dass sie das Problem erkannt hätten und ernst nähmen. Sie baten den Bundesminister der Justiz daher, zu prüfen, inwieweit die besonderen Gefahren durch Deepfakes eigener Regelungen, etwa im Rahmen des künftigen Gesetzes gegen Digitale Gewalt, bedürften.

Mobbing, Erpressung, Demokratieverzerrung

Auch Lea Katharina Kumkar, Juniorprofessorin an der Universität in Trier, die zum Recht der Digitalisierung und speziell zu Künstlicher Intelligenz forscht, sieht Handlungsbedarf. Die Entwicklung von Software, die Deepfakes generieren kann, habe in den vergangenen Jahren "einen riesigen Sprung gemacht", erklärt Kumkar im Gespräch. "Signifikante Bedeutung haben pornographische Deepfakes erlangt, wobei es schwierig ist, klare Zahlen zu nennen, da in diesem Bereich die Dunkelziffer extrem hoch ist." Diese zirkulierten vor allem in kleineren Netzwerken mit weniger Überwachung als bei Facebook und Co., außerdem über Messenger-Apps.

Ob zur Erpressung, als Racheakt oder zum Mobbing eingesetzt – für Betroffene sind solche Bilder sehr belastend, und das selbst dann, wenn schnell klar wird, dass die Aufnahme gar nicht echt ist. Das zeigt ein Fall aus Spanien, wo vermeintliche Nacktfotos von mehr als 20 Mädchen an einer Schule in WhatsApp-Gruppen kursierten. Die Bilder, auf denen die Mädchen eigentlich bekleidet waren, stammten von ihren Instagram-Konten und waren mittels generativer KI so bearbeitet worden, dass die Nacktheit täuschend echt aussah. Allein die Tatsache, dass solche Bilder über sie erstellt und verbreitet wurden, war für die Mädchen schwer zu verkraften.

Die beiden anderen großen Problemfelder von Deepfakes sind aus Sicht von Kumkar Betrugsszenarien wie etwa der beliebte Enkeltrick und der Einsatz für Fake-News. Das manipulierte Scholz-Video dürfte da nur ein Vorgeschmack sein. "Aktuell sehe ich noch nicht, dass die ganze Nachrichtenlandschaft damit geflutet würde", so Kumkar, aber in den USA seien Deepfakes von Politikern schon heute ein Problem. "Unsere Meinungslandschaft kann nur aufrechterhalten werden, wenn wir Vertrauen in eine gemeinsame Informationsgrundlage haben können und nicht jedes Mal fragen müssen, was richtig ist und was falsch." Doch während sich praktisch alle einig sind, dass etwas getan werden muss, gehen die Ansichten über das Wie auseinander.

Braucht es das Strafrecht?

Die auf der JuMiKo diskutierte Initiative ist nicht die einzige. Während Justizsenatorin Gallina eine Kennzeichnung von Deepfakes mittels Wasserzeichen ins Spiel bringt, beschloss der Bundesrat in seiner Sitzung am 5. Juli einen Gesetzentwurf aus Bayern, der eine strafrechtliche Regulierung für notwendig hält: "Bloße Kennzeichnungspflichten für Deepfakes werden dem persönlichkeitsrechtsverletzenden Charakter solcher Medieninhalte und den vielfach gravierenden Auswirkungen für die Betroffenen im Fall ihrer Verbreitung nicht gerecht", heißt es in der Entwurfsbegründung.

Der Bundesrat hat dabei besonders die pornografischen Deepfakes im Blick, die vom geltenden Strafrecht nicht voll erfasst seien. "Für die Betroffenen unterscheiden sich die schädlichen Auswirkungen kaum von denjenigen, in denen reale Nacktaufnahmen von ihnen unbefugt verbreitet werden", heißt es im Entwurf. Besondere strafrechtliche Regelungen gegen derartige Deepfakes gebe es bislang nicht. Die bestehenden Vorschriften erfassten das Phänomen allenfalls in Teilaspekten "und auch nicht in seinem Unrechtskern".

Aus diesem Grund fordert der Bundesrat eine "spezifisch auf Deepfakes und vergleichbare technische Manipulationen zugeschnittene Vorschrift zum Persönlichkeitsschutz im Strafgesetzbuch". Nach einem neuen § 201b StGB solle künftig mit bis zu zwei Jahren Freiheitsstrafe bestraft werden, "wer das Persönlichkeitsrecht einer anderen Person verletzt, indem er einen mit computertechnischen Mitteln hergestellten oder veränderten Medieninhalt, der den Anschein einer wirklichkeitsgetreuen Bild- oder Tonaufnahme des äußeren Erscheinungsbildes, des Verhaltens oder mündlicher Äußerungen dieser Person erweckt, einer dritten Person zugänglich macht".

Zivilrechtlerin Kumkar wollte sich gegenüber beck-aktuell mit einer strafrechtlichen Bewertung zurückhalten, hat aber aufgrund ihrer intensiven Arbeit zum Thema KI und Deepfakes Zweifel an der Sichtweise des Bundesrats: "Eine Vielzahl von Straftatbeständen deckt bereits den Einsatz von Deepfakes ab", so Kumkar. "Die Regelung hat meines Erachtens eher symbolischen Charakter." Ein solcher Tatbestand könne möglicherweise abschreckend wirken, wenn die Tat vom persönlichen Nahbereich des Opfers ausgehe, allerdings sei häufig überhaupt nicht klar, wer ein bestimmtes Foto erstellt habe. Zudem agierten unbekannte Täter mitunter aus dem Ausland, erpressten die Opfer von dort aus.

Ansprüche sind da, Durchsetzung ist das Problem

Zivilrechtlich gibt es schon Mittel und Wege, um gegen Deepfakes vorzugehen, etwa mittels Unterlassungsansprüchen, gestützt auf das Allgemeine Persönlichkeitsrecht oder das Recht am eigenen Bild aus dem KunstUrhG. Auch datenschutzrechtlich bestehen Ansprüche. "Die große Problematik liegt im Bereich der Durchsetzung", gibt Kumkar zu bedenken. Häufig wisse man nicht, woher ein Deepfake stamme, mit anderen Worten: gegen wen man überhaupt klagen solle. Sie hält es daher für sinnvoll, die Durchsetzung zivilrechtlicher Ansprüche zu erleichtern. Ein erster Schritt könnte das Gesetz gegen digitale Gewalt sein, das Auskunftsansprüche stärken und richterlich angeordnete Account-Sperren ermöglichen soll. Kumkar sieht aber unionsrechtliche Probleme, denn grundsätzlich regele der Digital Services Act (DSA) der EU diesen Themenkreis bereits abschließend.

Erfolgversprechender wäre es, meint Kumkar, weniger die Ersteller von Deepfakes als vielmehr die Anbieter von entsprechender Software sowie die Netzwerkbetreiber in die Pflicht zu nehmen. Entscheidend sei für Betroffene vor allem, die Inhalte schnellstmöglich aus dem Netz zu bekommen. Der Fall der mit pornografischen Deepfakes drangsalierten Schülerinnen aus Spanien bestätigt: Wasserzeichen helfen in diesem Bereich den Opfern wenig.

Reale Möglichkeiten, Deepfakes schnell zu erkennen und löschen zu lassen, gebe es, erklärt Kumkar: "Es wird nie möglich sein, alles zu 100% zu erfassen, wenn jemand mit genug Energie und Ressourcen, wie etwa ein staatlicher Geheimdienst, dahintersteht. Aber man kommt sehr weit gegen Deepfakes, die aus dem Wohnzimmer oder der Garage verschickt werden." Hierzu gelte es, die Plattformen, auf denen sie sich verbreiteten, in die Pflicht zu nehmen.

Erinnerungen an NetzDG

Die ganze Diskussion erinnert damit stark an die Debatten, die seinerzeit um Hassrede im Netz geführt wurde. Auch hier verbreiten sich verletzende oder gar gefährliche Inhalte über digitale Medien in einer rasenden Geschwindigkeit. Auch hier sind die Hintermänner und -frauen schwer zu ermitteln und für die Betroffenen ist vor allem wichtig, dass die Inhalte schnell gelöscht werden. Der deutsche Gesetzgeber reagierte seinerzeit mit dem umstrittenen NetzDG, welches ebenfalls die Plattformbetreiber in die Pflicht nahm, gemeldete Inhalte schnell zu prüfen und zu löschen.

Der EU-Gesetzgeber hat nicht nur mit dem DSA, sondern auch mit dem sogenannten AI-Act einiges getan, um mit den Entwicklungen von Künstlicher Intelligenz Schritt zu halten. In dem Paket hat die EU unter anderem eine Transparenzpflicht für Deepfakes implementiert. Allerdings weist die Regelung, die im Mai vom Rat beschlossen wurde, eine entscheidende Schwachstelle auf, wie Kumkar bemerkt: "Es ist sehr schade, dass ein Verstoß gegen die Kennzeichnungspflicht nicht automatisch dazu führt, dass der Adressat den Inhalt auch löschen muss. Das ist ein großer Fehler."

Mut macht indes, dass die großen Plattformbetreiber aktuell schon an Systemen feilen, die Deepfakes automatisiert erkennen und zielsicher löschen sollen. Die Motivation ist dabei keine altruistische, dafür aber besonders effektiv: Die Betreiber trainieren selbst KI-Systeme mit den Inhalten ihrer Plattform. Um wirklich gut zu werden, braucht eine KI aber "richtige" Daten. Tummeln sich auf einer Plattform zu viele Fälschungen, so wird auch die eigene KI auf Fälschungen trainiert. Das wollen die Betreiber verhindern.

Kumkar ist daher "insgesamt zuversichtlich, dass man Lösungen finden wird". Perspektivisch, so hofft sie, könnte die Entwicklung "wieder weggehen davon, dass jeder Nutzer Inhalteanbieter ist", hin zu einer Nachrichtenwelt, in der seriöse Quellen das Vertrauen dafür bieten, was echt ist und was nicht. "Wir sind von Kindesbeinen auf gewohnt, dass das, was wir als Bild oder Video gesehen haben, tatsächlich wahr ist“, so Kumkar. "Wir werden uns daran gewöhnen müssen, dass wir dieses Vertrauen nicht mehr haben dürfen."